Configuration RAID Niveau 6 (Striping avec double parité distribuée) dans Linux - Partie 5

- 3367

- 757

- Emilie Colin

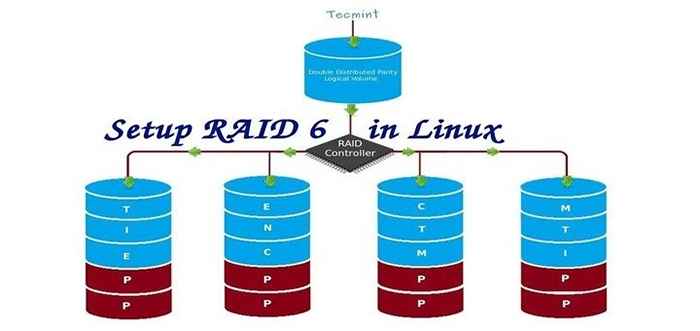

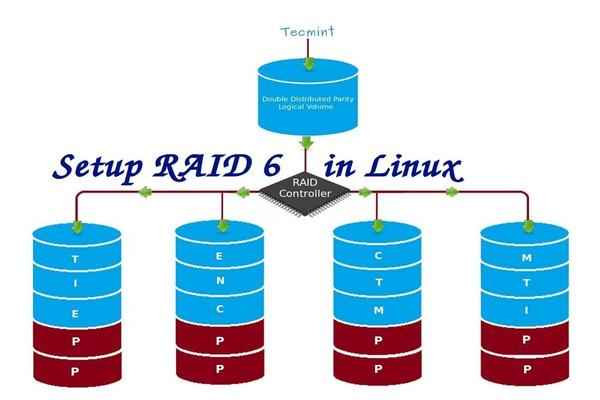

Raid 6 est la version améliorée de Raid 5, où il a deux parité distribuée qui fournit une tolérance aux défauts même après l'échec de deux disques. Mission Critical System Toujours opérationnel en cas de deux échecs de disques simultanés. C'est pareil Raid 5, mais fournit plus robuste, car il utilise un disque de plus pour la parité.

Dans notre article précédent, nous avons vu la parité distribuée dans Raid 5, Mais dans cet article, nous allons voir Raid 6 avec une double parité distribuée. Ne vous attendez pas à des performances supplémentaires que tout autre raid, si c'est le cas, nous devons également installer un contrôleur RAID dédié. Ici dans Raid 6 Même si nous perdons nos 2 disques, nous pouvons récupérer les données en remplaçant un lecteur de rechange et en le construisant à partir de parité.

Configuration Raid 6 en Linux

Configuration Raid 6 en Linux Pour configurer un Raid 6, le minimum 4 un nombre de disques ou plus dans un ensemble est requis. Raid 6 ont plusieurs disques même dans un ensemble, il peut être d'avoir des disques, pendant qu'il lira, il lira tous les disques, donc la lecture serait plus rapide alors que l'écriture serait médiocre car elle doit dépasser plusieurs disques.

Maintenant, beaucoup d'entre nous arrivent à la conclusion, pourquoi nous devons utiliser Raid 6, Quand il ne fonctionne pas comme un autre raid. Hmm… ceux qui soulèvent cette question doivent savoir que s'ils ont besoin d'une tolérance à la défaut élevée choisissent Raid 6. Dans tous les environnements supérieurs avec une grande disponibilité pour la base de données, ils utilisent Raid 6 Parce que la base de données est la plus importante et doit être sûre en tout coût, elle peut également être utile pour les environnements de streaming vidéo.

Pour les avantages et les inconvénients de Raid 6

- Les performances sont bonnes.

- RAID 6 est cher, car il nécessite que deux lecteurs indépendants sont utilisés pour les fonctions de parité.

- Perdra une capacité de deux disques d'utilisation des informations de parité (double parité).

- Aucune perte de données, même après l'échec de deux disques. Nous pouvons reconstruire à partir de la parité après avoir remplacé le disque échoué.

- La lecture sera meilleure que RAID 5, car elle se lit sur plusieurs disques, mais les performances de l'écriture seront très médiocres sans contrôleur RAID dédié.

Exigences

Un minimum de 4 nombres de disques sont nécessaires pour créer un Raid 6. Si vous souhaitez ajouter plus de disques, vous pouvez, mais vous devez avoir un contrôleur RAID dédié. En raid logiciel, nous n'aurons pas de meilleures performances dans Raid 6. Nous avons donc besoin d'un contrôleur de raid physique.

Ceux qui sont nouveaux dans la configuration des raids, nous vous recommandons de passer par des articles RAID ci-dessous.

- Concepts de base de RAID dans Linux - Partie 1

- Création de logiciels Raid 0 (Stripe) dans Linux - Partie 2

- Configuration du raid 1 (miroir) dans Linux - Partie 3

Ma configuration de serveur

Système d'exploitation: Centos 6.5 Adresse IP finale: 192.168.0.228 Nom d'hôte: RD6.ténineux.com disque 1 [20 Go]: / dev / sdb disque 2 [20 Go]: / dev / sdc disque 3 [20 Go]: / dev / sdd disque 4 [20 Go]: / dev / sde

Cet article est un Partie 5 d'une série RAID à 9 tutoriels, nous allons voir comment nous pouvons créer et configurer un logiciel Raid 6 ou rayer avec une parité distribuée double dans des systèmes ou des serveurs Linux en utilisant quatre disques de 20 Go nommés / dev / sdb, / dev / sdc, / dev / sdd et / dev / sde.

Étape 1: Installation de l'outil MDADM et examinez les lecteurs

1. Si vous suivez nos deux derniers articles RAID (Partie 2 et PArt 3), où nous avons déjà montré comment installer 'mdadm' outil. Si vous êtes nouveau dans cet article, laissez-moi expliquer cela 'mdadm`` est un outil pour créer et gérer RAID dans Linux Systems, installons l'outil à l'aide de la commande suivante en fonction de votre distribution Linux.

# YUM INSTALLATION MDADM [sur RedHat Systems] # APT-Get Installer MDADM [sur Debain Systems]

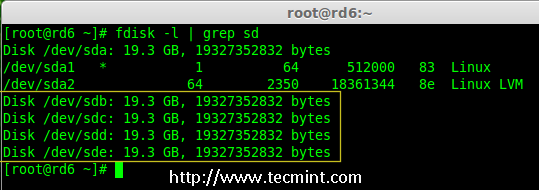

2. Après avoir installé l'outil, il est maintenant temps de vérifier les quatre disques attachés que nous allons utiliser pour la création de RAID en utilisant les suivants »fdisk' commande.

# fdisk -l | Grep SD

Vérifiez les disques dans Linux

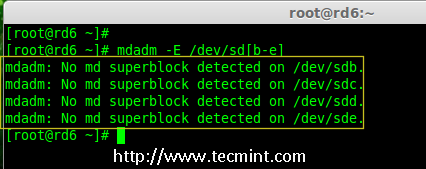

Vérifiez les disques dans Linux 3. Avant de créer un RAID Drives, examinez toujours nos disques disques s'il y a un raid est déjà créé sur les disques.

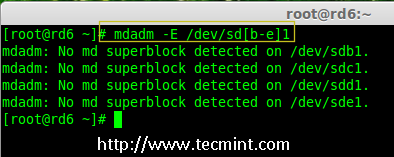

# mdadm -e / dev / sd [b-e] # mdadm --examine / dev / sdb / dev / sdc / dev / sdd / dev / sde

Vérifiez le raid sur le disque

Vérifiez le raid sur le disque Note: Dans l'image ci-dessus illustre qu'il n'y a aucun super-bloc détecté ou aucun raid n'est défini en quatre disques. Nous pouvons aller plus loin pour commencer à créer un raid 6.

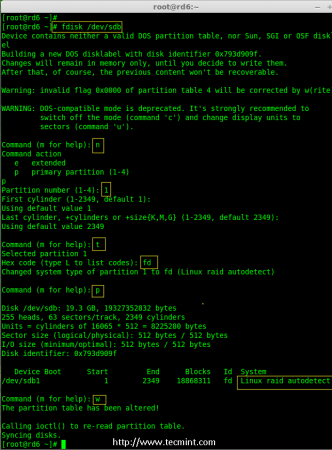

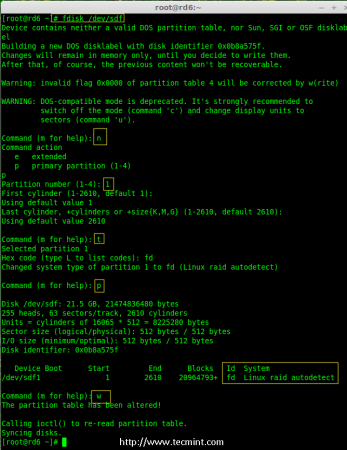

Étape 2: Partitionnement de conduite pour Raid 6

4. Créez maintenant des partitions pour raid sur '/ dev / sdb','/ dev / sdc','/ dev / sdd' et '/ dev / sde'avec l'aide de suivre fdisk commande. Ici, nous montrerons comment créer une partition sur SDB conduire et plus tard les mêmes étapes à suivre pour le reste des disques.

Créer / Dev / SDB Partition

# fdisk / dev / sdb

Veuillez suivre les instructions comme indiqué ci-dessous pour créer une partition.

- Presse 'n'Pour créer de nouvelles partitions.

- Alors choisi 'P'Pour la partition primaire.

- Choisissez ensuite le numéro de partition comme 1.

- Définissez la valeur par défaut en appuyant simplement deux fois Entrer clé.

- Suivant appuyez surP'Pour imprimer la partition définie.

- Presse 'L'Pour énumérer tous les types disponibles.

- Taper 't'Pour choisir les partitions.

- Choisir 'FD'Pour Linux Raid Auto et appuyez sur Entrée pour appliquer.

- Puis à nouveau utiliser 'P'Pour imprimer les modifications ce que nous avons apporté.

- Utiliser 'w'Pour écrire les changements.

Créer / Dev / SDB Partition

Créer / Dev / SDB Partition Créer / Dev / SDB Partition

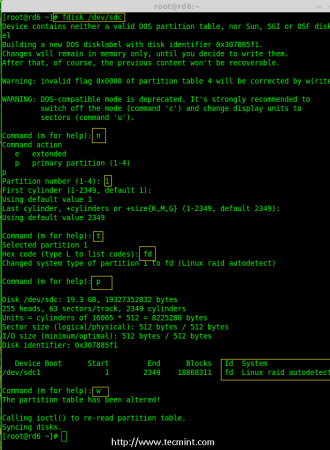

# fdisk / dev / sdc

Créer / Dev / SDC Partition

Créer / Dev / SDC Partition Créer / Dev / SDD Partition

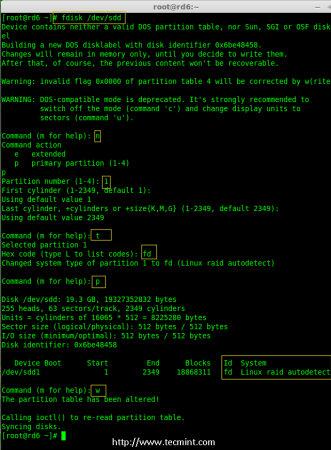

# fdisk / dev / sdd

Créer / Dev / SDD Partition

Créer / Dev / SDD Partition Créer / Dev / SDE Partition

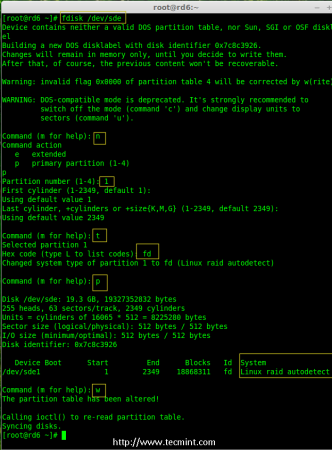

# fdisk / dev / sde

Créer / Dev / SDE Partition

Créer / Dev / SDE Partition 5. Après avoir créé des partitions, c'est toujours une bonne habitude d'examiner les disques de super-blocs. Si les super-blocs n'existent pas, nous pouvons aller de la tête pour créer une nouvelle configuration de raid.

# mdadm -e / dev / sd [b-e] 1 ou # mdadm --examine / dev / sdb1 / dev / sdc1 / dev / sdd1 / dev / sde1

Vérifiez le raid sur de nouvelles partitions

Vérifiez le raid sur de nouvelles partitions Étape 3: Création d'un appareil MD (RAID)

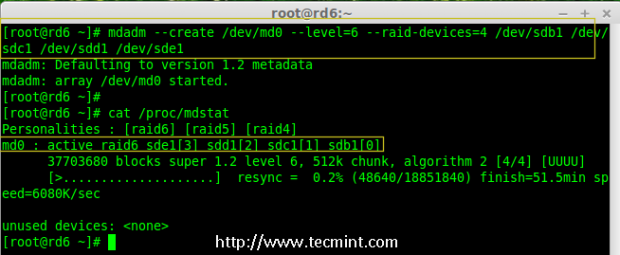

6. Il est maintenant temps de créer un appareil RAID 'md0' (je.e. / dev / md0) et appliquer le niveau de raid sur toutes les partitions nouvellement créées et confirmer le raid en utilisant les commandes suivantes.

# mdadm --create / dev / md0 --level = 6 --raid-devices = 4 / dev / sdb1 / dev / sdc1 / dev / sdd1 / dev / sde1 # cat / proc / mdstat

Créer un appareil RAID 6

Créer un appareil RAID 6 7. Vous pouvez également vérifier le processus actuel de RAID en utilisant montre Commande comme indiqué dans l'écran Grab ci-dessous.

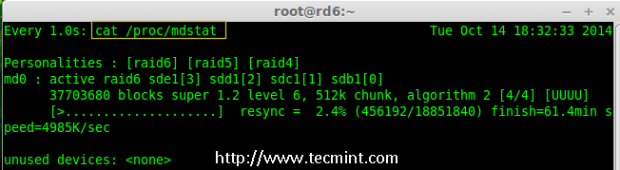

# watch -n1 cat / proc / mdstat

Vérifier le processus RAID 6

Vérifier le processus RAID 6 8. Vérifiez les périphériques RAID à l'aide de la commande suivante.

# mdadm -e / dev / sd [b-e] 1

Note:: La commande ci-dessus sera afficher les informations des quatre disques, ce qui est assez long, donc pas possible de publier la sortie ou la saisie d'écran ici.

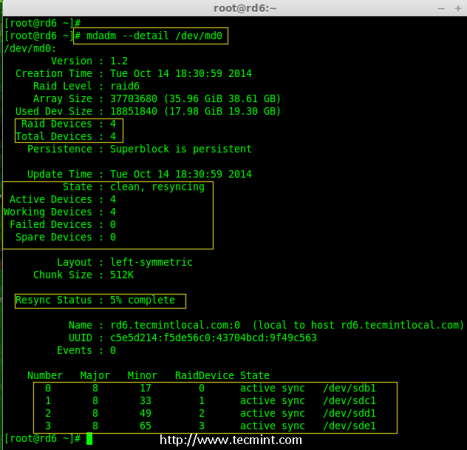

9. Ensuite, vérifiez le tableau des raids pour confirmer que la re-synchronisation est démarrée.

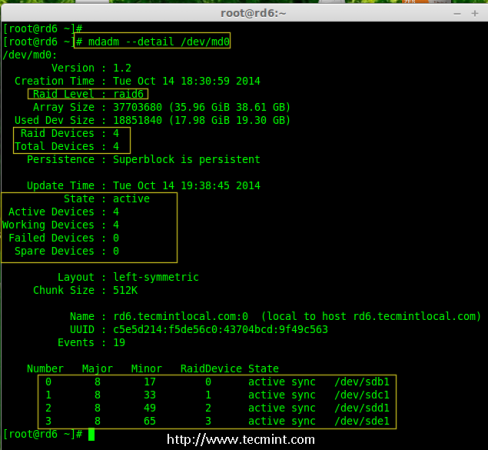

# MDADM --Detail / Dev / MD0

Vérifiez le raid 6 tableau

Vérifiez le raid 6 tableau Étape 4: Création du système de fichiers sur l'appareil RAID

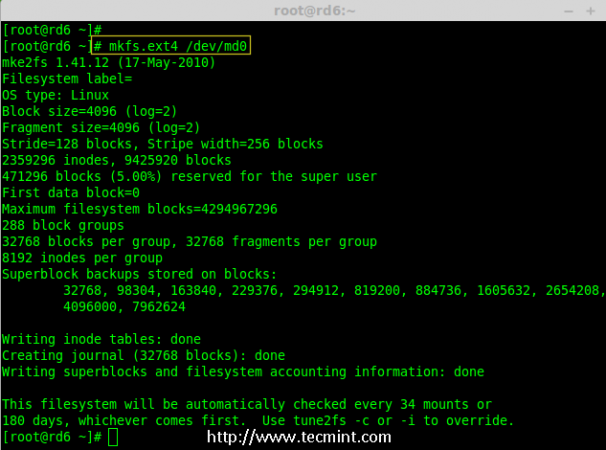

dix. Créer un système de fichiers à l'aide d'EXT4 pour '/ dev / md0'Et montez-le sous / mnt / raid6. Ici, nous avons utilisé EXT4, mais vous pouvez utiliser n'importe quel type de système de fichiers selon votre choix.

# MKFS.ext4 / dev / md0

Créer un système de fichiers sur Raid 6

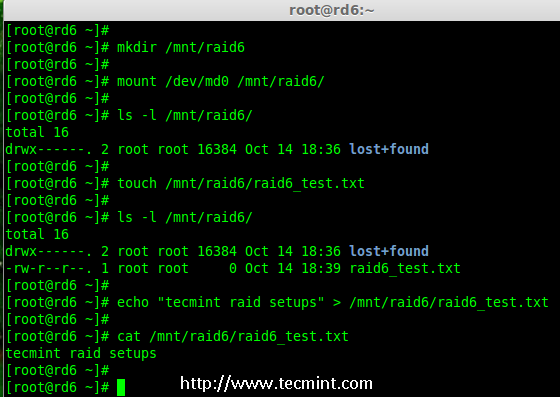

Créer un système de fichiers sur Raid 6 11. Monter le système de fichiers créé sous / mnt / raid6 Et vérifiez les fichiers sous point de montage, nous pouvons voir le répertoire perdu + trouvé.

# mkdir / mnt / raid6 # mont / dev / md0 / mnt / raid6 / # ls -l / mnt / raid6 /

12. Créez des fichiers sous Mount Point et ajoutez un texte dans l'un des fichiers pour vérifier le contenu.

# touch / mnt / raid6 / raid6_test.txt # ls -l / mnt / raid6 / # echo "Configuration de raid tecmint"> / mnt / raid6 / raid6_test.TXT # CAT / MNT / RAID6 / RAID6_TEST.SMS

Vérifiez le contenu RAID

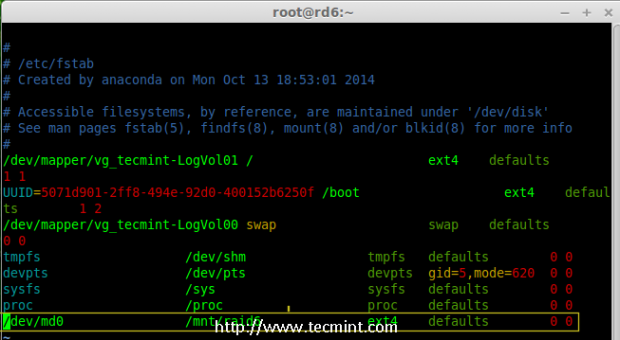

Vérifiez le contenu RAID 13. Ajouter une entrée dans / etc / fstab Pour monter automatiquement l'appareil au démarrage du système et ajouter l'entrée ci-dessous, le point de montage peut différer en fonction de votre environnement.

# vim / etc / fstab / dev / md0 / mnt / raid6 ext4 par défaut 0 0

Automount Raid 6 Device

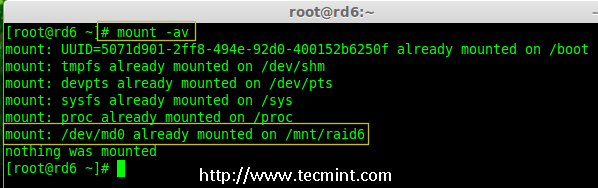

Automount Raid 6 Device 14. Ensuite, exécutez 'mont -a'Commande pour vérifier s'il y a une erreur dans l'entrée fstab.

# mont -av

Vérifiez Raid Automount

Vérifiez Raid Automount Étape 5: Enregistrer la configuration du raid 6

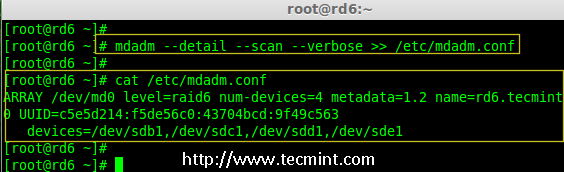

15. Veuillez noter par défaut Raid n'a pas de fichier de configuration. Nous devons l'enregistrer en utilisant manuellement la commande ci-dessous, puis vérifier l'état de l'appareil '/ dev / md0'.

# MDADM - DETAIL - SCAN --verbose >> / etc / mdadm.Conf # mdadm - Detetail / dev / md0

Enregistrer la configuration RAID 6

Enregistrer la configuration RAID 6  Vérifier le statut RAID 6

Vérifier le statut RAID 6 Étape 6: Ajout d'un disque de rechange

16. Maintenant il a 4 disques et il y a deux informations de parité disponibles. Dans certains cas, si l'un des disques échoue, nous pouvons obtenir les données, car il y a une double parité dans RAID 6.

Peut être si le deuxième disque échoue, nous pouvons en ajouter un nouveau avant de perdre le troisième disque. Il est possible d'ajouter un lecteur de rechange lors de la création de notre ensemble de raids, mais je n'ai pas défini le lecteur de rechange lors de la création de notre ensemble de raids. Mais, nous pouvons ajouter un lecteur de rechange après n'importe quelle panne de lecteur ou lors de la création de l'ensemble RAID. Maintenant, nous avons déjà créé l'ensemble des raids maintenant permettez-moi d'ajouter un lecteur de rechange pour la démonstration.

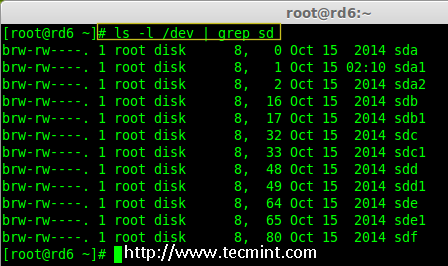

Pour la démonstration, j'ai tiré à chaud un nouveau disque de disque dur (je.e. / dev / sdf), vérifions le disque attaché.

# ls -l / dev / | Grep SD

Vérifiez le nouveau disque

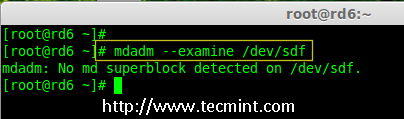

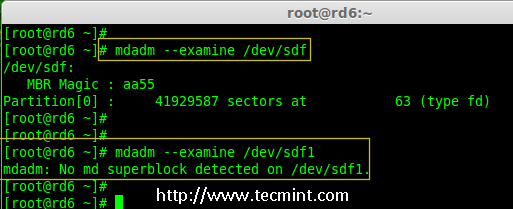

Vérifiez le nouveau disque 17. Maintenant, confirmez à nouveau le nouveau disque ci-joint pour tout raid est déjà configuré ou n'utilise pas le même mdadm commande.

# mdadm --examine / dev / sdf

Vérifiez le raid sur un nouveau disque

Vérifiez le raid sur un nouveau disque Note: Comme d'habitude, comme nous avons créé des partitions pour quatre disques plus tôt, de même, nous devons créer de nouvelles partitions sur le nouveau disque branché en utilisant fdisk commande.

# fdisk / dev / sdf

Créer / Dev / SDF Partition

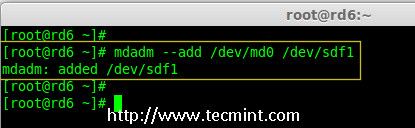

Créer / Dev / SDF Partition 18. Encore une fois après avoir créé une nouvelle partition sur / dev / sdf, Confirmez le raid sur la partition, incluez le lecteur de rechange / dev / md0 RAID DIPPORTION ET VÉRIFIER LE PRISE AJOUTÉ.

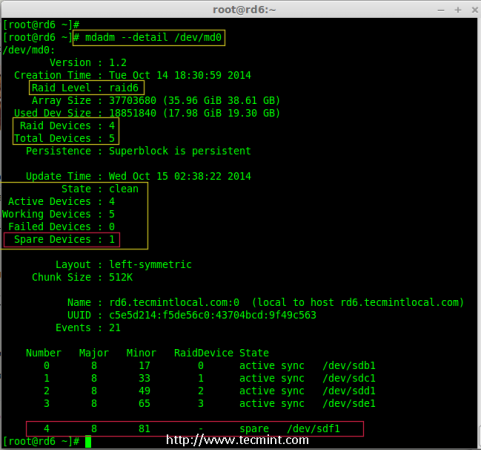

# mdadm --examine / dev / sdf # mdadm --examine / dev / sdf1 # mdadm --add / dev / md0 / dev / sdf1 # mdadm --detet / dev / md0

Vérifiez le raid sur la partition SDF

Vérifiez le raid sur la partition SDF  Ajouter une partition SDF à Raid

Ajouter une partition SDF à Raid  Vérifiez les détails de partition SDF

Vérifiez les détails de partition SDF Étape 7: Vérifiez le raid 6 tolérance aux défauts

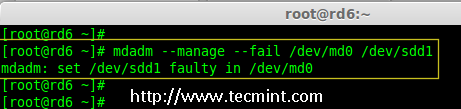

19. Maintenant, vérifions si le lecteur de rechange fonctionne automatiquement, si quelqu'un du disque échoue dans notre tableau. Pour les tests, j'ai personnellement marqué l'un des entraînements est échoué.

Ici, nous allons marquer / dev / sdd1 comme un entraînement échoué.

# MDADM --MANAGE - FAIL / DEV / MD0 / DEV / SDD1

Vérifiez le raid 6 tolérance aux défauts

Vérifiez le raid 6 tolérance aux défauts 20. Permettez-moi d'obtenir les détails de Raid Set maintenant et vérifiez si notre rechange a commencé à se synchroniser.

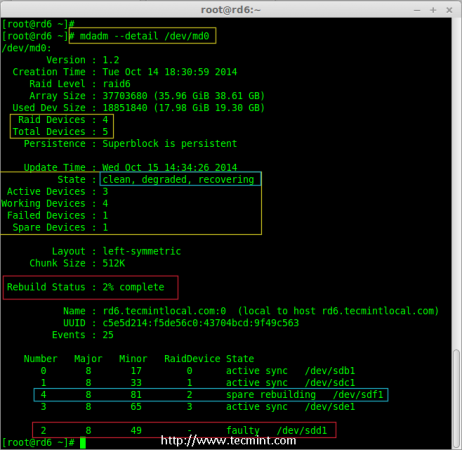

# MDADM --Detail / Dev / MD0

Vérifier la synchronisation des raids automobiles

Vérifier la synchronisation des raids automobiles Hourra! Ici, nous pouvons voir que la rechange a été activée et a commencé le processus de reconstruction. En bas, nous pouvons voir le lecteur défectueux / dev / sdd1 répertorié comme défectueux. Nous pouvons surveiller le processus de construction en utilisant la commande suivante.

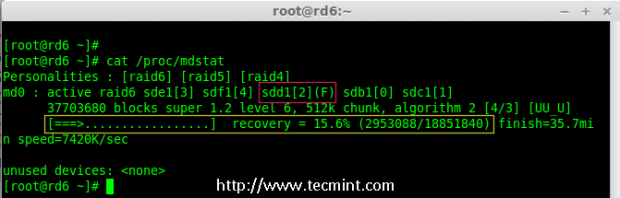

# CAT / PROC / MDSTAT

RAID 6 SYNCING AUTO

RAID 6 SYNCING AUTO Conclusion:

Ici, nous avons vu comment configurer Raid 6 en utilisant quatre disques. Ce niveau de raid est l'une des configurations coûteuses avec une redondance élevée. Nous verrons comment configurer un Raid imbriqué 10 Et bien plus dans les prochains articles. Jusque-là, restez connecté avec Tecmint.

- « Comment passer à partir d'Ubuntu 16.10 à Ubuntu 17.04

- 10 raisons pour lesquelles vous devriez utiliser l'éditeur de texte vi / vim dans Linux »