Comment installer et configurer Apache Spark sur Ubuntu / Debian

- 4154

- 149

- Thomas Richard

Apache Spark est un cadre de calcul distribué open source qui est créé pour fournir des résultats de calcul plus rapides. Il s'agit d'un moteur de calcul en mémoire, ce qui signifie que les données seront traitées en mémoire.

Étincelle Prend en charge diverses API pour le streaming, le traitement des graphiques, SQL, MLIB. Il prend également en charge Java, Python, Scala et R comme les langues préférées. Spark est principalement installé dans des grappes Hadoop, mais vous pouvez également installer et configurer Spark en mode autonome.

Dans cet article, nous verrons comment installer Apache Spark dans Debian et Ubuntu-distributions basées.

Installez Java et Scala dans Ubuntu

À installer Apache Spark Dans Ubuntu, vous devez avoir Java et Scala Installé sur votre machine. La plupart des distributions modernes sont livrées avec Java installé par défaut et vous pouvez le vérifier en utilisant la commande suivante.

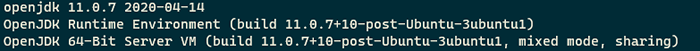

$ java -version

Vérifiez la version Java dans Ubuntu

Vérifiez la version Java dans Ubuntu Si aucune sortie, vous pouvez installer Java en utilisant notre article sur la façon d'installer Java sur Ubuntu ou simplement exécuter les commandes suivantes pour installer Java sur les distributions basées sur Ubuntu et Debian.

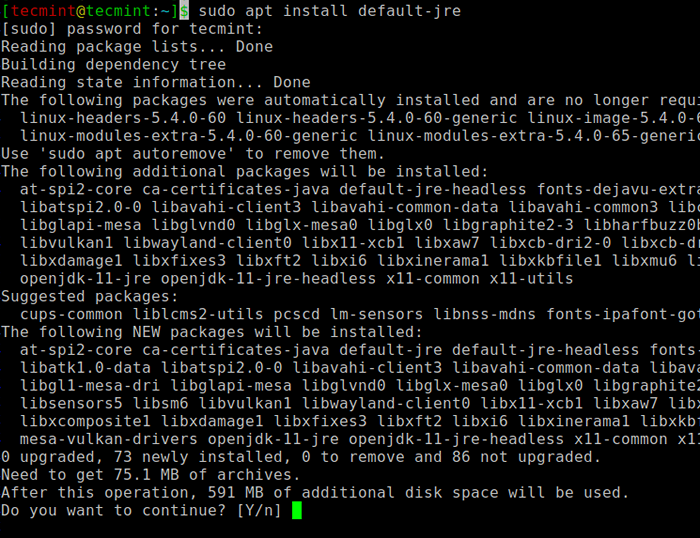

$ sudo apt Update $ sudo apt installer par défaut-jre $ java -version

Installer Java à Ubuntu

Installer Java à Ubuntu Ensuite, vous pouvez installer Scala à partir du référentiel APT en exécutant les commandes suivantes pour rechercher Scala et l'installer.

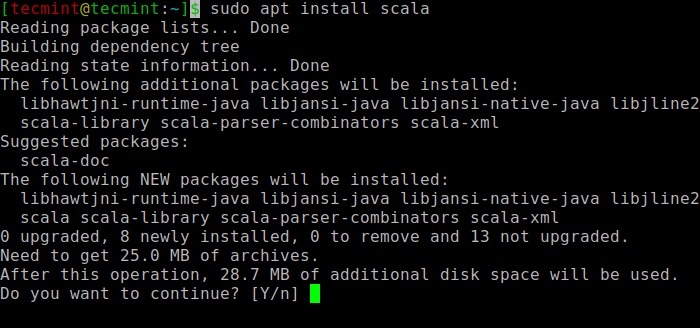

$ sudo apt Search scala ⇒ recherche le package $ sudo apt installer scala ⇒ installer le package

Installez Scala dans Ubuntu

Installez Scala dans Ubuntu Pour vérifier l'installation de Scala, Exécutez la commande suivante.

$ Scala -version Scala Code Runner Version 2.11.12 - Copyright 2002-2017, Lamp / EPFL

Installez Apache Spark dans Ubuntu

Accédez maintenant à la page de téléchargement officielle Apache Spark et prenez la dernière version (I.e. 3.1.1) Au moment de la rédaction de cet article. Alternativement, vous pouvez utiliser la commande wget pour télécharger le fichier directement dans le terminal.

$ wget https: // apachemirror.wuchna.com / Spark / Spark-3.1.1 / Spark-3.1.1-bin-hadoop2.7.tgz

Ouvrez maintenant votre terminal et passez à l'endroit où votre fichier téléchargé est placé et exécutez la commande suivante pour extraire le fichier Apache Spark Tar.

$ TAR -XVZF Spark-3.1.1-bin-hadoop2.7.tgz

Enfin, déplacez l'extrait Étincelle répertoire de /opter annuaire.

$ sudo mv spark-3.1.1-bin-hadoop2.7 / Opt / Spark

Configurer les variables environnementales pour Spark

Vous devez maintenant définir quelques variables environnementales dans votre .profil fichier avant de démarrer l'étincelle.

$ echo "Export Spark_Home = / Opt / Spark" >> ~ /.Profil $ echo "Export Path = $ path: / opt / spark / bin: / opt / spark / sbin" >> ~ /.profil $ echo "Exporter pyspark_python = / usr / bin / python3" >> ~ /.profil

Pour s'assurer que ces nouvelles variables d'environnement sont accessibles dans le shell et disponibles pour Apache Spark, il est également obligatoire d'exécuter la commande suivante pour mettre en vigueur les changements récents.

$ source ~ /.profil

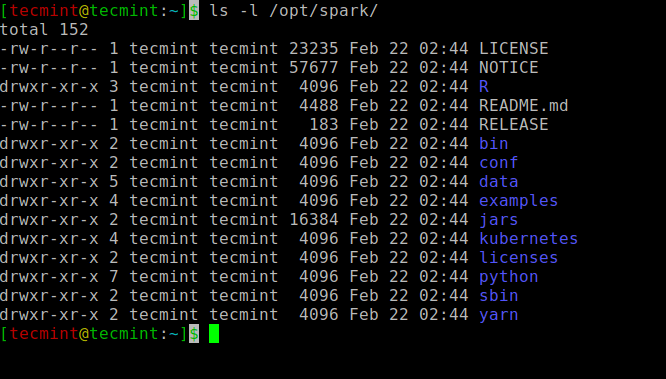

Tous les binaires liés à l'étincelle pour démarrer et arrêter les services sont sous le sbin dossier.

$ ls -l / opt / spark

Binaires étincelants

Binaires étincelants Démarrer Apache Spark dans Ubuntu

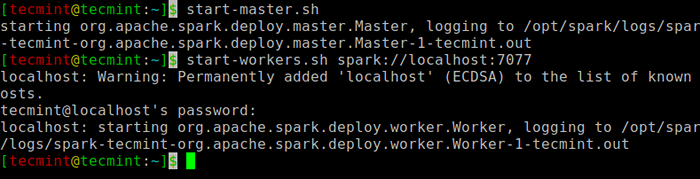

Exécutez la commande suivante pour démarrer le Étincelle Service de maître et service esclave.

$ start-master.SH $ start-workers.sh Spark: // localhost: 7077

Démarrer le service Spark

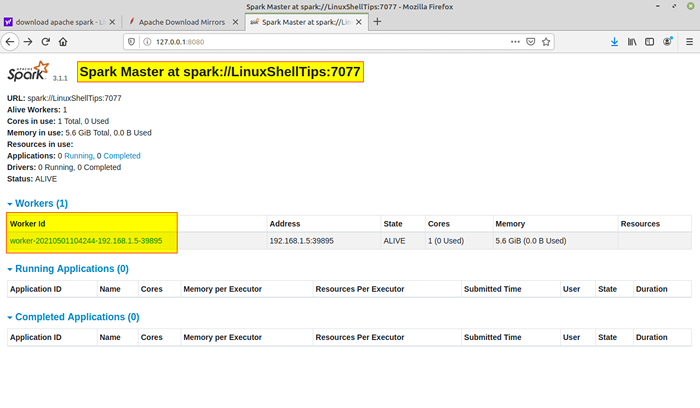

Démarrer le service Spark Une fois le service démarré, allez au navigateur et saisissez la page d'étincelle d'accès à l'URL suivante. Depuis la page, vous pouvez voir mon service maître et esclave est démarré.

http: // localhost: 8080 / ou http: // 127.0.0.1: 8080

Page Web Spark

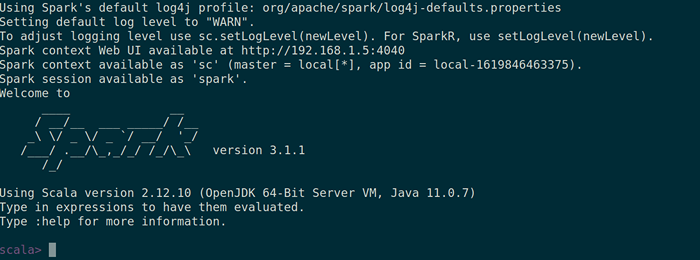

Page Web Spark Vous pouvez également vérifier si coquille d'étincelle fonctionne bien en lançant le coquille d'étincelle commande.

$ spark-shell

Coquille d'étincelle

Coquille d'étincelle C'est tout pour cet article. Nous vous attraperons très bientôt avec un autre article intéressant.

- « LFCA apprend les coûts du cloud et la budgétisation - Partie 16

- Comment surveiller le serveur Linux et traiter les mesures du navigateur »